-

- ■産学連携

- 国際交流

- ダイバーシティ

- 情報理工学の創造的展開プロジェクト

- 受賞・表彰

![]()

「街中でおもしろそうなものを見つけましたが、周りに誰もいなくて、結局、何だかわかりませんでした。もし、そこに誰かいたら、マイクを向けて『これって、何ですか』と質問するところですが」─。新聞記者のような役を演じているのは、原田准教授が育てているロボット。取材のノウハウ(知能)を与えて記者に仕立て上げようとしている、その名もズバリ『ジャーナリストロボット』である。単に、身の回りで起きたことをカメラで観察するだけでなく、ニュース性があるかどうかを発見し、記事にする賢さを持たせる。まだ半人前にもいかないが、コア技術となっている画像アノテーションと、今後コアになる画像セグメンテーションの2つの技術をひも解くと、ジャーナリストロボットの賢さとともに、その先の目標が見えてくる。

「街中でおもしろそうなものを見つけましたが、周りに誰もいなくて、結局、何だかわかりませんでした。もし、そこに誰かいたら、マイクを向けて『これって、何ですか』と質問するところですが」─。新聞記者のような役を演じているのは、原田准教授が育てているロボット。取材のノウハウ(知能)を与えて記者に仕立て上げようとしている、その名もズバリ『ジャーナリストロボット』である。単に、身の回りで起きたことをカメラで観察するだけでなく、ニュース性があるかどうかを発見し、記事にする賢さを持たせる。まだ半人前にもいかないが、コア技術となっている画像アノテーションと、今後コアになる画像セグメンテーションの2つの技術をひも解くと、ジャーナリストロボットの賢さとともに、その先の目標が見えてくる。

|

| ジャーナリストロボットがニュースを発見!! |

| ※画面をクリックしてムービーをご覧下さい |

動画をお見せしよう。廊下のテーブルの上に置いた花をジャーナリストロボットが近寄りながら発見する様子である。カメラで捉えた「廊下」、「窓」、「植物」、「テーブル」、「床」を文字で表示する。カギを握る技術の1つが画像アノテーション。インターネットや家庭のPCなどには膨大な画像情報があふれている。その中から、画像をパッと見たときにそれが何かを瞬時に認識し、単語で表示するものだ。ロボットは将来、モノを持って歩いたり、障害物を避けながら歩いたり、複数の仕事を抱えて動くにちがいない。そんなとき、ロボットが自分で見たものが何かを1、2分待ってからでないと判断できないようでは、複数の仕事を同時にこなすことはむずかしい。瞬時に行動を起こせるようにするには、認識スピードを速くすることが求められる。原田准教授が見いだしたアノテーション技術は「めちゃくちゃ速い」のだ。2007年開発当時、2割6分ほどだった認識精度を3割以上に高め、最新のPCクラスター3000台をつないで1時間もかかっていた学習時間を、市販のデスクトップPC1台で数分程度に大幅に短縮した。認識時間は何と1万倍も速い。

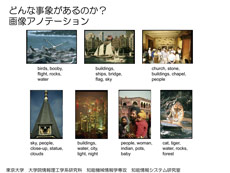

下に7枚の画像がある。それぞれの画像の下に単語を示しているが、これは入力された未知の画像を画像アノテーションによる認識システムが判断して割り付けたものだ。システムは大量の画像と単語を関連付けたデータセットを利用して学習している。画像については、細かい部分をすべて認識するのではなく、色と形をまぜこぜにしたような特徴を利用し、単語については、単語同士の関連性の知識を事前に何も与えていない。ここにいままで見たこともない画像が入力されると、画像の見た目の近さと、付いている単語列の近さから画像と単語列との関連性を学習するアルゴリズムを利用して、入力画像に適切な単語列を選び出す。たとえば、イヌ、クマ、鳥などの概念を自分で構築する知能を持っているので、関連する画像と単語列を高速、高精度で選択が可能である。

|

|

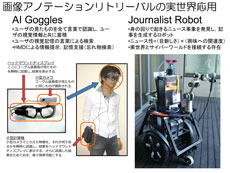

| 画像アノテーションの例 | 画像アノテーションを利用すると、「AIゴーグル」や「ジャーナリストロボット」が見えてくる |

| ※画面をクリックして拡大画像をご覧下さい | |

「ロボットにとって、知識をどんな方法で獲得するかが一番のボトルネックなんです。情報をほしい人の意図や注目点に沿って画像と単語を選び出すことをゴールとすれば、私たちの手法は確かな一歩を刻むものです」。この画像アノテーション技術がAIゴーグルやジャーナリストロボットといった新しいシステムを生み出そうとしている。AIゴーグルは、眼鏡の上に取り付けたカメラで部屋全体を捉えると、映像とともに、映像が何を示すか、その名前を小型計算機が認識し、結果を眼鏡の横にあるHMDに表示する。これが標準辞書となり、そのあとゴーグルを装着して部屋の中を見回したときの映像がHMDに送られ、先の標準辞書と瞬時に比較してその名前も表示する。これを使えば、「いままで貯めた自分の記憶を言葉で検索できます。インターネットによって世界中の情報を探すことは可能になりましたが、自分自身の経験は探せないまま。それができるんです」。また、どこかに置き忘れてしまったケータイ電話や玄関のカギ、クルマのキーなども探せる。思い出し支援の有力なツールになるのだ。

ジャーナリストロボットは、リアル世界とサイバーワールドをつなぐロボットという位置付けである。インタビューしながら取得した画像から「ニュース性がある」「あまり受けそうにない」などをすばやく判断できるようにするが、すでに、ニュース性に応じて単語を表示するところまで機能を高めてきた。現時点では、アノテーション技術によってテーブルの上に花があるのはわかるのだが、その花を手に取って確かめたい場合には、別の手法がいる。画像からモノを切り出すセグメンテーション技術がそれに応えるものだ。ロボットは形を知らないとモノを持てないので、ロボットにモノを取ってきてもらうには、モノの位置と形状の情報を的確に伝えないといけない。原田准教授らは、モノの位置と形、つまり、2.5次元の立体情報を切り出せるようにしたところがきわめて先進的である。

原田准教授が展開している画像セグメンテーション研究で注目すべき点は「ロボット自体にモノの形を判断するモデルを持たせていない」ことだ。通常、ロボットは、ペットボトルならこんな形というモデルを持っていて、それとマッチングを取って判断しているが、グシャッとつぶれていたりすると、マッチングはできなくなる。衣類とか柔らかい素材も扱えるようにしないと、高度な知識を入れたとしても、どこかで破綻してしまう。環境に依存しない柔軟な対応を目指しているのがわかる。

こう見てくると、原田准教授の真の研究の目的が明確になってくる。ジャーナリストロボットはAIゴーグルと同様に、画像アノテーション技術を駆使して、見たものを瞬時に言葉として表現する“情報支援のロボット”ということができる。“物理支援”を実現する画像セグメンテーション技術と組み合わせることで、「あの本を読みたい。電話がかかってきたので、ケータイを取って」という人のリクエストに確実に応える新しいロボットが浮上する。原田准教授には、そのマイルストーンがキッチリと見えている。

Copyright © 2019 Graduate School of Information Science and Technology, The University of Tokyo